Apache Airflow는 데이터 파이프라인 작업을 스케줄링하고 관리하는 데 사용되는 강력한 오픈 소스 플랫폼입니다. Airflow를 구성하는데 로컬에 설치할 수도 있고, 클라우드에 설치할 수 도 있지만, 여기서는 Docker에 설치하는 방법을 알아보겠습니다.

1. Docker 및 Docker Compose 설치

Docker를 설치하려면 Docker 공식 웹 사이트를 방문하고 OS에 맞는 설치 방법을 확인하세요. Docker Compose도 함께 설치해야 합니다.

2. Airflow Compose 구성 파일 다운로드

Airflow를 설치하기 전에 환경 변수와 설정 파일을 구성해야 합니다. 터미널을 여시고, docker-compose.yml 파일을 아래 링크에서 다운 받을 수 있습니다.

curl -LfO '<https://airflow.apache.org/docs/apache-airflow/2.7.1/docker-compose.yaml>'

이 파일은 PostgreSQL과 Airflow 웹 서버 컨테이너, worker, scheduler 를 정의하며, Airflow 설정과 DAGs 를 로컬 디렉터리와 공유합니다. 포트 8080을 통해 Airflow 웹 인터페이스에 접속할 수 있습니다.

3. 초기 Airflow 환경 세팅

mkdir -p ./dags ./logs ./plugins ./config

echo -e "AIRFLOW_UID=$(id -u)" > .env

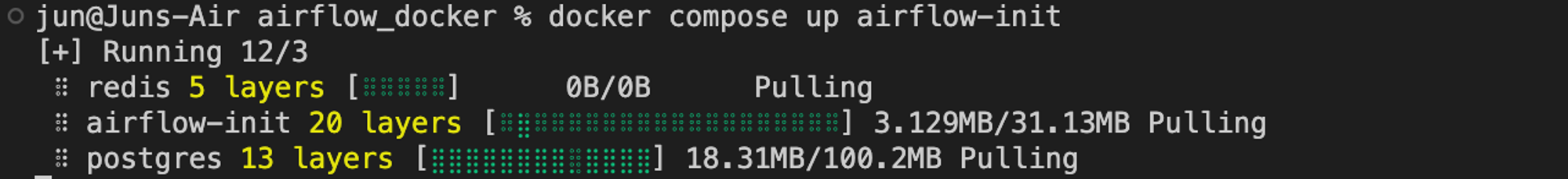

4. Airflow 초기화

Airflow 웹 서버 컨테이너를 실행하기 전에 데이터베이스를 초기화해야 합니다. 다음 명령을 사용하여 초기화합니다. 이 때 docker-compose.yaml 파일이 필요합니다.

docker-compose up airflow-init

초기화 진행 후, 도커 컨테이너가 실행 되고 있을 수 있습니다. 아래는 초기화 컨테이너를 제거하는 방법입니다.

5. Airflow 실행

이제 Airflow를 실행할 차례입니다. 다음 명령으로 컨테이너를 시작할 수 있습니다.

docker-compose up

Airflow 웹 인터페이스는 http://localhost:8080에서 접속할 수 있습니다.

6. Airflow 프로세스 확인

설치를 마치며

Apache Airflow 설치를 위해 Docker를 사용하여 설치하고 실행하는 방법을 알아보았습니다. Airflow를 활용하여 데이터 워크플로를 자동화할 수 있습니다. 필요에 따라 DAGs를 추가하고 더 복잡한 작업 스케줄링을 설정할 수 있습니다.

참고 자료 및 영상

https://airflow.apache.org/docs/apache-airflow/stable/howto/docker-compose/index.html